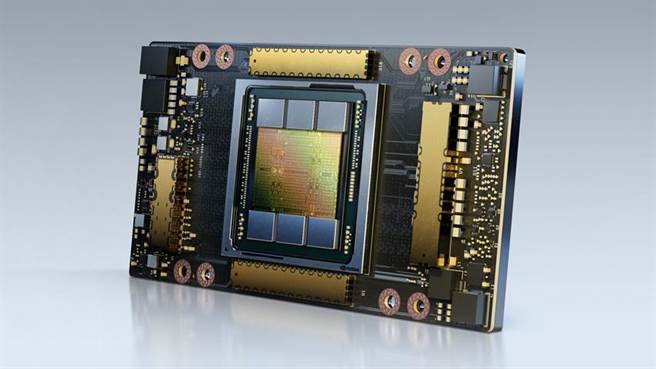

繪圖晶片大廠NVIDIA(輝達)揭曉支援 NVIDIA HGX AI 超級運算平台的 NVIDIA A100 80GB GPU,其記憶體容量較前一代多出一倍,為研究人員與工程師帶來前所未有的速度與效能,解鎖新一波 AI 與科學研究突破的潛能。

全新A100搭載HBM2e技術,將A100 40GB GPU的高頻寬記憶體容量加倍至80GB,並提供每秒超過2 terabytes(TB)的記憶體頻寬。如此充裕的頻寬讓資料能快速匯入全球最快的資料中心GPU A100,讓研究人員能進一步推升其應用的速度,以處理更龐大的模型與資料集。

NVIDIA深度學習應用研究部門副總裁Bryan Catanzaro表示,若想獲得高效能運算(HPC)與人工智慧(AI)最頂尖的研究成果,就必須建立極龐大的模型,而這也代表將會需要比過去更多的記憶體容量和傳輸頻寬。A100 80GB GPU提供比六個月前推出的前一代GPU多一倍的記憶體容量,還突破每秒 2TB 的頻寬瓶頸,讓研究人員能克服全球最重要的科學與大數據研究難題。

NVIDIA A100 80GB GPU現已搭載於NVIDIA DGXTM A100和17日發表的NVIDIA DGX StationTM A100系統,預計在本季開始出貨。

包括Atos、戴爾科技、富士通、技嘉、慧與科技、浪潮、聯想、廣達和美超微(Supermicro)等頂尖系統大廠,預計於2021上半年開始提供整合四個或八個 A100 80GB GPU 基板的 HGX A100 。

建立於具備多元功能的A100 40GB,此次推出的80GB版本能因應龐大資料記憶體的需求,適用於更大範圍的應用。

在AI訓練方面,例如DLRM這類含有大量表格以記載數十億名用戶及數十億項產品的推薦系統模型,由於A100 80GB能提供3倍的加速效果,因此企業能快速重新訓練這些模型,以提供高精準度的建議。

此外,A100 80GB還能訓練最龐大的模型,透過套用更多參數,導入到配備單一HGX的伺服器,例如GPT-2是一個運用自然語言處理模型來執行超越人類的文字生成功能。如此一來就不再需要耗費大量時間建置資料或模型平行處理架構,而且這類技術在跨多個節點運行時速度過慢。

憑藉本身具備的多執行個體GPU(MIG)技術,A100可切分成7個GPU執行個體,而單一個體配有10GB的記憶體,構成安全無虞的硬體分隔區,並能為各種規模較小的作業負載提供最高的GPU資源使用率。對於像RNN-T這類自動語音辨識模型的AI推論,光靠一個 A100 80GB MIG執行個體就能處理更大的批量,在生成環境中的推論吞吐量提高1.25倍。

在 TB 規模的零售業大數據分析基準方面,A100 80GB 能產生最高 2 倍的效能,故能針對龐大的資料集快速獲得洞察,而企業則能透過這些隨時更新的資料即時做出關鍵決策。

在諸如氣象預報及量子化學等科學應用方面,A100 80GB 能提供強大的加速效果。例如像 Quantum Espresso 這款材料模擬軟體,在單節點 A100 80GB 系統運行可達到接近 2 倍的資料產出量提升。

日本理化學研究所計算科學研究中心 (RIKEN Center for Computational Science) 主任松岡聰表示,加速且充裕的記憶體頻寬與容量,是實現高效能超級運算應用的關鍵條件。NVIDIA A100 結合 80GB 的 HBM2e GPU 記憶體,以每秒2 TB帶來全球最快的傳輸頻寬,將為應用挹注大幅提升的效能表現。

A100 80GB GPU 是 NVIDIA HGX AI 超級運算平台的關鍵元素,匯集了 NVIDIA GPU、NVIDIA NVLink、NVIDIA InfiniBand 網路技術的力量,加上完全優化的 NVIDIA AI 與 HPC 軟體堆疊,發揮最高的應用效能。它讓研究人員與科學家能結合 HPC、資料分析及深度學習運算方法,推動科學研究的進展。

發表意見

中時新聞網對留言系統使用者發布的文字、圖片或檔案保有片面修改或移除的權利。當使用者使用本網站留言服務時,表示已詳細閱讀並完全了解,且同意配合下述規定:

違反上述規定者,中時新聞網有權刪除留言,或者直接封鎖帳號!請使用者在發言前,務必先閱讀留言板規則,謝謝配合。